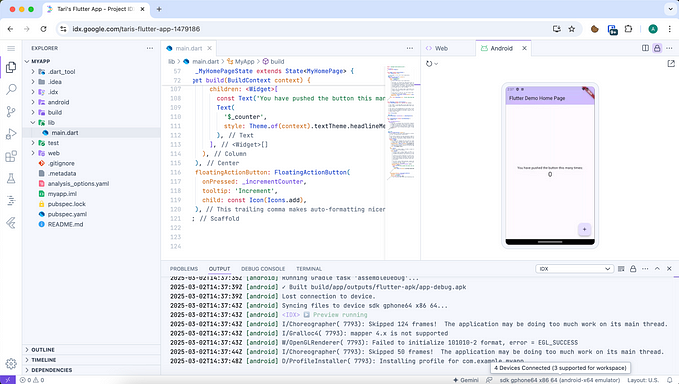

A Revolução da IA no mercado financeiro

Qual é a visão fundamentalista de alguém de tecnologia para esse o mercado, já que todo mundo só fala disso agora?

Apesar de não ser um especialista no campo de inteligência artificial — até mesmo um cara de tecnologia com o meu histórico é leigo nessas questões, de tão complexas que são — , venho sendo muito questionado por algumas pessoas sobre a minha visão do mercado de IA, incluindo a famosa pergunta de “se é uma bolha ou não” e onde estou investindo.

Disclaimer: parece óbvio mas é bom falar que eu não sou analista financeiro, não recomendo ações e tudo o que eu falo aqui é minha mera e humilde opinião particular.

O Papel dos Tensores e as Limitações das CPUs

No coração da IA, especialmente em Deep Learning, estão os chamados tensores, que são essencialmente arranjos multidimensionais de dados. Estes tensores permitem que grandes quantidades de informações sejam processadas e manipuladas de forma eficaz, o que é crucial para o treinamento de modelos de IA.

Limitações das CPUs no Processamento de IA

As CPUs têm sido o cérebro dos computadores por décadas, mas elas não são otimizadas para o tipo de operações maciças e paralelas que os tensores exigem. As CPUs são projetadas para maximizar o desempenho em uma ampla gama de tarefas gerais, mas suas limitadas capacidades de processamento paralelo significam que elas não podem processar rapidamente grandes volumes de operações tensoriais, que são a espinha dorsal do Deep Learning. Isso resulta em um gargalo significativo devido ao volume e à complexidade dos cálculos envolvidos.

A Descoberta das GPUs

Em contraste, as GPUs têm se revelado notavelmente aptas para lidar com operações de IA. Originalmente projetadas para renderizar gráficos complexos em jogos e aplicações visuais, as GPUs possuem uma arquitetura paralela que as torna extremamente eficientes para trabalhar com tensores. Essa capacidade foi uma descoberta surpreendente e não intencional no campo da IA, onde a capacidade de processar rapidamente grandes volumes de operações tensoriais se traduz em uma aceleração significativa do treinamento de modelos.

Essa adequação das GPUs para o processamento de IA foi inicialmente subestimada pelas big techs, que demoraram a adaptar seus produtos e serviços para aproveitar plenamente as capacidades das GPUs.

Na surdina, a OpenAI, com o lançamento de LLMs acessíveis aos ~meros mortais~ usuários finais, desencadeou uma corrida tecnológica que agora vê as GPUs no centro da infraestrutura de IA.

Surpresa no Mercado

A Resposta das Big Techs

Muitas das Big Techs foram lentas em adotar e adaptar suas estratégias para tirar proveito das capacidades das GPUs. Este atraso ocorreu em parte porque o potencial das GPUs para IA só se tornou amplamente reconhecido após pesquisadores e startups menores começarem a experimentar e alcançar resultados notáveis. Entre elas, a OpenAI foi particularmente influente ao democratizar o acesso a LLMs, como o GPT, lançando-os para o público geral e mostrando o poder das GPUs.

Agora as Big Techs correm para alcançar a OpenAI, como:

- a Microsoft (MSFT) que fez um investimento bilionário na companhia e lançou principalmente o Copilot como seu carro-chefe de AI;

- o Google (GOOG), que lançou seu LLM concorrente ao ChatGPT e integrado aos seus outros produtos, o Gemini, e também continua investindo na popularização dos seus próprios microchips voltados à AI, as TPUs;

- a Apple (AAPL), que não só anunciou AI no core de seus produtos, mas também no seu próprio hardware;

- a Samsung (KRX:005930), que também lançou funcionalidades de software e hardware ligadas à AI.

Nvidia: Líder Preparada

Neste cenário, a Nvidia (NVDA) emergiu como a líder indiscutível, sendo a única fabricante que tinha hardware não apenas pronto, mas bem adaptado às demandas específicas de IA em termos de funcionalidades de chip e memória de vídeo (VRAM). O desempenho superior das GPUs da Nvidia em tarefas de Deep Learning colocou a empresa em uma posição privilegiada, tornando-a um fornecedor essencial para empresas que buscam infraestrutura para executar operações intensivas de IA.

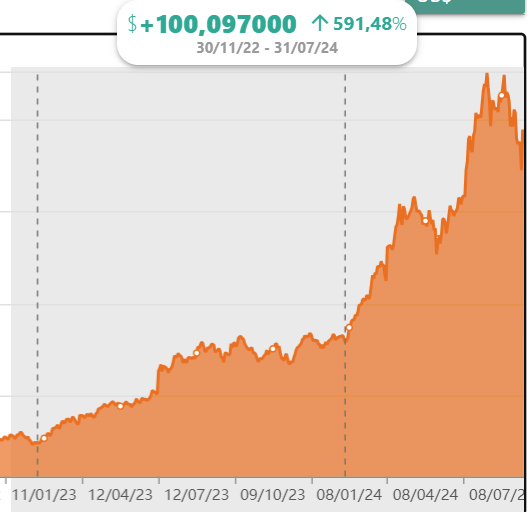

Desde o lançamento do ChatGPT, em 30 de novembro de 2022, a Nvidia teve um aumento exponencial no valor das suas ações. A título de exemplo, na data de escrita desse artigo, a companhia teve uma valorização de US$ 100 por ação, um aumento de 591% contado da data do lançamento do ChatGPT.

É óbvio que a tensão ainda paira no mercado em relação a esse crescimento da Nvidia ser uma bolha ou não. O bull market é muito emocionado e tende a especular bastante em torno do papel agora, tornando-o bem sensível a qualquer notícia do mercado, como a recente investigação por antitruste pelo Senado dos EUA.

Mas a empresa continua entregando resultados cada vez mais incríveis, pagando atualmente um Dividend Yield de ~0,04% (média FW anual), num P/E Ratio de 15,44x.

A Dependência Atual das Big Techs

Atualmente, a dependência das Big Techs em relação à Nvidia é notável. Elas precisam de poder de processamento que apenas as GPUs avançadas da Nvidia podem oferecer de forma eficiente, o que tem gerado uma relação de quase monopolização no fornecimento de hardware de IA.

Isso sugere que, pelo menos no próximo ano, investir na Nvidia pode ser uma jogada astuta, considerando a contínua expansão do mercado de IA e a posição dominante da empresa.

O Futuro dos Chips de IA

À medida que a demanda por IA continua a crescer, o desenvolvimento de microchips especializados se tornou um campo de batalha crucial para as Big Techs. A necessidade de processamento mais eficiente e poderoso está impulsionando uma onda de inovações e investimentos significativos no design de chips específicos (ASICs).

Empresas como Google, Samsung e Apple já estão fazendo progressos significativos. O Google, por exemplo, desenvolveu as TPUs, que são projetados especificamente para acelerar o treinamento e a inferência de modelos de machine learning em seus data centers. Esses chips são uma parte fundamental da estratégia do Google para manter sua liderança em serviços baseados em IA, como o assistente de voz e a busca avançada.

Samsung e Apple, por sua vez, estão integrando capacidades de IA diretamente em seus dispositivos, desenvolvendo chips que permitem funcionalidades avançadas de processamento no dispositivo — o que chamamos de Edge Computing — , o que é essencial para reduzir a carga de Cloud Computing em AI.

Desafios para AMD, Intel e Qualcomm

Enquanto isso, empresas tradicionalmente dominantes em outros segmentos de chips, como AMD, Intel e Qualcomm, estão enfrentando desafios para se adaptar rapidamente ao mercado emergente de IA.

A Intel (INTC), apesar de sua liderança em PCs, e a Qualcomm (QCOM), com sua forte presença em dispositivos móveis, estão trabalhando para recuperar o terreno perdido para competidores que foram mais rápidos na adaptação às necessidades de IA, mas não mostram sinais muito significativos de inovação nesse campo.

A AMD (AMD), conhecida por suas GPUs competitivas, também não mostra novidades tão incríveis na busca para suportar aplicações de IA.

Oportunidades de Investimento

As empresas que estão na vanguarda do desenvolvimento de chips de IA estão bem posicionadas para capitalizar sobre a crescente onda de aplicações de inteligência artificial. Investir nessas empresas pode ser uma estratégia prudente, dado o potencial de crescimento no setor — que, na minha opinião, não é uma bolha, mas sim uma nova revolução industrial.

Além disso, a computação de borda, que requer processamento de dados no local para reduzir a latência e aumentar a eficiência, está se tornando cada vez mais importante. Isso sugere um mercado robusto para chips de IA que podem operar eficientemente em ambientes com restrições de energia e espaço, como dispositivos móveis e IoT.

A Crescente Demanda de RAM para Modelos de IA

À medida que a complexidade e o tamanho dos LLMs continuam a aumentar, a demanda por memória RAM também tem visto um crescimento significativo. Este aumento é impulsionado pela necessidade de armazenar e processar quantidades enormes de dados e parâmetros que esses modelos avançados requerem.

Desafios de Hardware Atuais

Os PCs tradicionais e as placas de vídeo, embora continuem evoluindo, ainda enfrentam limitações significativas em termos de quantidade de memória RAM disponível. Essas limitações tornam difícil para esses dispositivos suportar os LLMs mais robustos, que necessitam de uma quantidade substancial de memória para operar eficientemente. A disparidade entre as capacidades de hardware disponíveis e as exigências dos modelos de IA está forçando os desenvolvedores e fabricantes a buscar um equilíbrio entre acurácia e eficiência operacional.

Um exemplo bem recente é o lançamento do Llama 3.1, modelo de LLM aberto da Meta, que surgiu com mais de 405 bilhões de parâmetros, algo praticamente impossível de ser executado em um hardware de uso pessoal.

Nesse sentido, quanto mais os modelos se tornam mais complexos, mais difícil é para eles serem processados nos computadores e dispositivos pessoais. O que nos leva de volta à nuvem para computação de IA, enquanto as empresas não encontrarem um meio-termo entre acurácia e eficiência de recursos.

O Papel das Empresas de Memória RAM

Neste contexto, as empresas que fabricam e fornecem memória RAM estão se tornando cada vez mais críticas para a infraestrutura de tecnologia. Empresas como ADATA (TPex: 3560), Sandisk/Western Digital (WDC), Samsung, SK HYNIX (KRX: 000660) e Micron (MU) estão na vanguarda dessa tendência, visto que a demanda por memória de alta capacidade está crescendo não apenas nos PCs e dispositivos móveis, mas especialmente em servidores e data centers operados por grandes empresas de tecnologia e provedores de nuvem.

RAM para a Computação em Nuvem e de Borda

As aplicações de nuvem, que permitem a operação de modelos de IA em grande escala, dependem intensamente de grandes quantidades de RAM para gerenciar e processar dados em tempo real. Além disso, com o aumento do foco em computação de borda, a necessidade de memória eficiente e compacta também está aumentando. Isso deve impulsionar inovações em tipos de memória que podem oferecer alta performance mesmo em condições de espaço e energia limitados.

Perspectivas para Investidores

Para investidores, o mercado de memória RAM oferece oportunidades substanciais, dada a importância crítica dessa tecnologia para o avanço e a implementação de IA. As empresas que estão se adaptando rapidamente para atender a essa demanda estão bem posicionadas para benefícios financeiros no futuro próximo. Considerando a tendência crescente em direção a dispositivos e aplicações mais inteligentes e interconectados, o investimento em fabricantes de memória RAM pode ser uma jogada estratégica e lucrativa.

Esse texto nasceu de um áudio meu no WhatsApp, que consolidei em uma lista de tópicos e, por fim, mandei pro ChatGPT me ajudar a escrever nesse prompt aqui. Lógico que não usei o que ele produziu na íntegra, adaptei muito ao meu estilo de escrita e adicionei bastante informação atualizada. Mas é o meu primeiro post co-escrito por AI.